最先端をキャッチアップし続けられる

人材になることを目指す

近年の機械学習エンジニアには、ディープラーニングの基本的な実装力だけではなく、日々進化しているディープラーニングの最先端をキャッチアップできる能力も求められます。

しかし、日々数多くの論文が投稿される中で、独力でカバーするのは、難易度が高く、効率的とは言えません。

そこで本講座では、ディープラーニング講座で触れる重要DL論文の理解からさらに一歩先を目指し、最先端をキャッチアップし続けられる人材となることを目指します。

E資格の合格率を高めることはもちろん、E資格取得後の継続的な学びの場としてもご活用ください。

※当講座は2024/03/29に講座名を変更しました。旧講座名「ディープラーニング最新論文講座」

得られる知識・スキル

-

ディープラーニングに関する研究動向

-

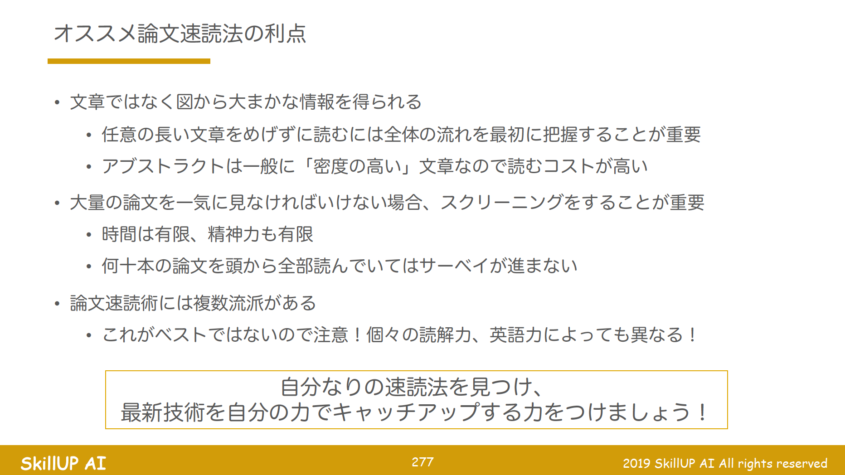

ディープラーニング論文を自力でキャッチアップできる力論文の概要を素早く掴む読み方を習得できるようになります。

-

E資格の点数アップ(最新の研究に関する出題の可能性があります)

こんな方におすすめ

- 日本ディープラーニング協会のE資格試験を受験される予定の方、E資格を取得済みの方

- 自力で論文を読むきっかけを掴みたい方

カリキュラム

コンピュータビジョン編自然言語処理(NLP)編ニューラルネットワーク(NN)系一般編強化学習(RL)編

合計31本の重要論文の概要に加えて 最後は「論文の読み方」について伝授します。

取り扱い論文

- Deep Residual Learning for Image Recognition

- モダンなCNNの主要技術であるResNetの原論文

- Squeeze-and-Excitation Networks

- ResNetと並んでCNNの汎化性能の基本技術になりうるSE moduleの原論文

- U-Net: Convolutional Networks for Biomedical Image Segmentation

- 医療分野で活躍するCNNであり、少数データからセグメンテーションを可能とする

- MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications

- 組み込み向けCNNの構成技術であり、スマホ等で使われている

- Efficient Neural Architecture Search via Parameter Sharing

- ENASと呼ばれるNNの自動設計手法の提案論文

- DARTS: Differentiable Architecture Search

- ENASに関連、NNの自動設計を行うNNをBPで学習する手法の提案

- Population Based Augmentation: Efficient Learning of Augmentation Policy Schedules

- タスクに効果的なデータ水増しの方法を学習する手法の提案

- Image-to-Image Translation with Conditional Adversarial Networks

- Pix2pixと呼ばれる画像変換用のGANの原論文

- Spherical CNNs

- 球面上の画像に対するCNNの提案論文

担当講師

筑波大学システム情報工学研究科修了、産業技術総合研究所人工知能研究センターに在籍中。博士(工学)。数理的・生物的な観点による深層学習モデルの解析、機械学習技術の実社会応用に関する研究に従事。日本ディープラーニング協会主催の第1回G検定の成績優秀者表彰、情報処理学会 山下記念研究賞、IEEE CISJ Young Researcher Awardほか受賞多数。

合計31本の重要論文の概要に加えて 最後は「論文の読み方」について伝授します。

取り扱い論文

- Memory Networks

- LSTM以上の長期記憶を実現した質疑応答用DNN

- End-To-End Memory Networks

- 全体をBPで学習可+多層化したMemory Networks。Attention機構の再発見という意味で非常に重要な論文

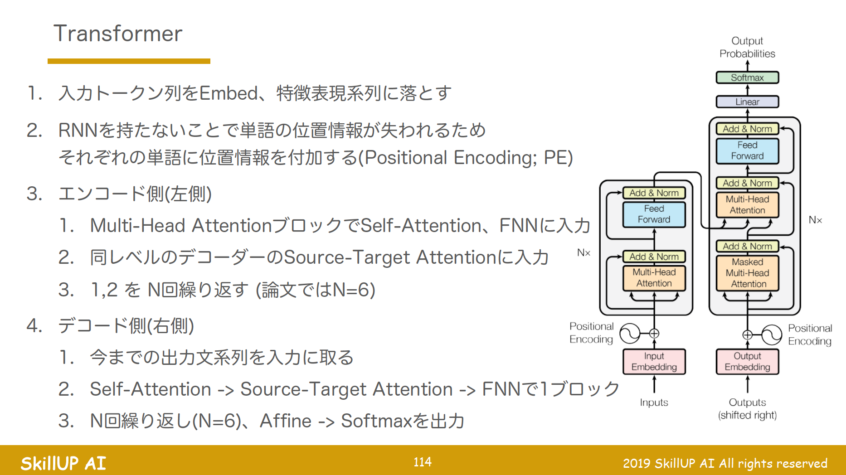

- Attention Is All You Need

- 現在のNLPタスクの主流になっているTransformerモデルの原論文であり、タイトルが非常にキャッチー、パクリタイトル論文が多数存在する

- BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding

- 最近出たNLPタスクの決定的モデル、あらゆるタスクでSotAを達成した

- XLNet: Generalized Autoregressive Pretraining for Language Understanding

- BERTの問題を解決した後発の万能NLPモデル

- Neural Turing Machine

- DNNで「計算」そのものをモデリングしようという試み

- Ordered Neurons: Integrating Tree Structures into Recurrent Neural Networks

- 言語に表れる階層構造をinductive biasとしてLSTMに導入

担当講師

筑波大学システム情報工学研究科修了、産業技術総合研究所人工知能研究センターに在籍中。博士(工学)。数理的・生物的な観点による深層学習モデルの解析、機械学習技術の実社会応用に関する研究に従事。日本ディープラーニング協会主催の第1回G検定の成績優秀者表彰、情報処理学会 山下記念研究賞、IEEE CISJ Young Researcher Awardほか受賞多数。

合計31本の重要論文の概要に加えて 最後は「論文の読み方」について伝授します。

取り扱い論文

- Distilling the Knowledge in a Neural Network

- モデル軽量化の主流手法、小さなモデルに知識を蒸留する

- Born Again Neural Networks

- Self-distillation(自己蒸留)によってNNを生まれ変わらせる手法の提案

- Explaining and Harnessing Adversarial Examples

- ニューラルネットワークを騙すような入力Adversarial Exampleについて

- Dataset Distillation

- 上2本に関連、「NNが好きな入力」を使って、「データを」蒸留する試み

- Linear Backprop in non-linear networks

- 性能を変えずにBPの計算を高速にする手法

- Understanding Batch Normalization

- DNNの学習に必要不可欠なバッチ正規化の解析論文

- Modeling Relational Data with Graph Convolutional Networks

- 画像ではなく”関係性”を畳み込もうという新しいネットワーク

- On the Convergence of Adam and Beyond

- 広く用いられる最適化アルゴリズムAdamの問題点を提示

- The Lottery Ticket Hypothesis: Finding Sparse, Trainable Neural Networks

- 宝くじ仮説と呼ばれるNNの初期値に関する重大仮説を提案

- Obfuscated Gradients Give a False Sense of Security: Circumventing Defenses to Adversarial Examples

- Obfuscated gradientsと呼ばれるAdversarial Attackへの防御手法の回避方法

- Delayed Impact of Fair Machine Learning

- AIが差別的な意思決定を行わないようにするFairness制約の問題点を提示

- Unsupervised Domain Adaptation by Matching Distributions based on the Maximum Mean Discrepancy via Unilateral Transformations

- 教師なしでのドメイン適応を行うカーネルベース手法の提案

担当講師

筑波大学システム情報工学研究科修了、産業技術総合研究所人工知能研究センターに在籍中。博士(工学)。数理的・生物的な観点による深層学習モデルの解析、機械学習技術の実社会応用に関する研究に従事。日本ディープラーニング協会主催の第1回G検定の成績優秀者表彰、情報処理学会 山下記念研究賞、IEEE CISJ Young Researcher Awardほか受賞多数。

合計31本の重要論文の概要に加えて 最後は「論文の読み方」について伝授します。

取り扱い論文

- Mastering the game of Go without human knowledge

- 人工知能の火付け役、AlphaGoの進化版 • 教師あり学習から完全自律の教師なしモデルに進化した

- Guided Cost Learning: Deep Inverse Optimal Control via Policy Optimization

- 強化学習の新しい考え方「逆強化学習」を解こう、という試み

- Generative Adversarial Imitation Learning

- GANのアイデアを元にしたImitation Learningのアルゴリズム Generative Adversarial Imitation Learning (GAIL)を提案

担当講師

筑波大学システム情報工学研究科修了、産業技術総合研究所人工知能研究センターに在籍中。博士(工学)。数理的・生物的な観点による深層学習モデルの解析、機械学習技術の実社会応用に関する研究に従事。日本ディープラーニング協会主催の第1回G検定の成績優秀者表彰、情報処理学会 山下記念研究賞、IEEE CISJ Young Researcher Awardほか受賞多数。

講座概要

| 講座名 | ディープラーニング重要論文講座 |

|---|---|

| 受講形式 |

オンライン講座:eラーニング形式 お好きな時間、お好きな場所でeラーニング形式にて受講いただけます。 |

| 前提となる知識・スキル |

必須スキル

|

| 講座時間 | 動画講義約9時間 |

| 料金 | 165,000円/1名(税込) ※ディープラーニング講座をお申し込み済みの方は、50%OFFで受講いただけます。 |

| 料金に標準で含まれるもの |

|

| 動画の視聴期間 | 動画共有日から1年間 |

FAQ

-

動画講義はいつまで視聴できますか?また、どうやって視聴しますか?視聴開始日ご提供日から1年間です。動画は、弊社ラーニングマネジメントシステム(LMS)にて視聴可能です。受講料のお支払い確認後、アカウント登録に関するメールをお送りします。

メール送信元:no-reply@skillupai-lms.com

※最新の教材提供を行うため、本コースは合成音声を利用する場合がございます。